初创公司 Cerebras 披露的数据显示,以 Meta 开源大模型 Llama3.1-70B 为例,其推理解决方案的速度是基于 Nvidia GPU 的公有云服务商速度的 20x 倍以上。

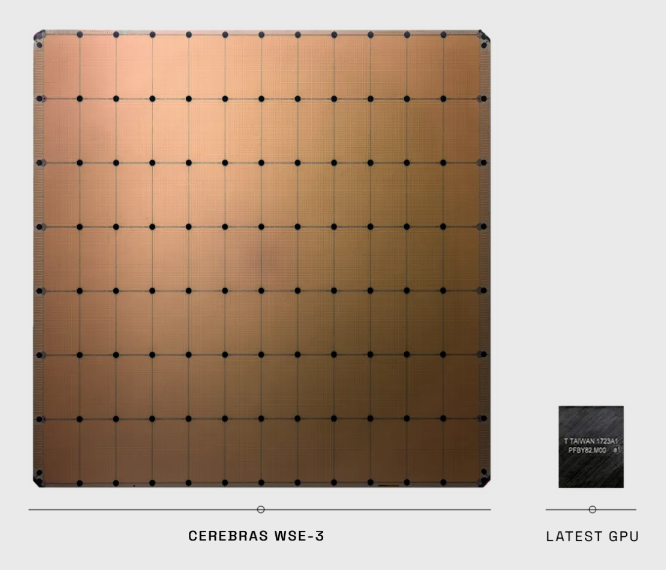

从披露的信息看,Cerebras 制造的推理芯片尺寸比 GPU 要大得多。

附:Llama3.1 有三种规格,8B 适合在消费者级 GPU 上进行高效部署和开发;70B 适合大规模 AI 原生应用;而 405B 则适用于合成数据等。

Deutsche Bank 分析了微软在 2022 ~ 2025 连续四年的分季度云计算算力订单规模,趋势就是 “屡创新高”。

作为 Gen AI 提供计算资源的 “卖铲子的人”,云端算力服务需求暂未看到放缓趋势。

OMDIA 咨询公司的数据显示,Nvidia H100 GPU 在 2023 年的出货中,采购量最大的客户是Microsoft 和 Meta,分别在 15 万套。

Google、Amazon、Oracle 和腾讯位居第二梯队,分别在 5 万套左右。

高性能 GPU 的采购体现了生成式 AI 带来的军备竞赛状态。

风险投资机构 BVP 绘制了一张图,用一条巨鲸来形容AI 创新的玩家分布。

处于头部的是 Google, Open AI + 微软;Anthropic 是前 OpenAI 离职员工创建;尾部的是 AI 的热门开源模型。

和一般的长尾不同,这条 “巨鲸” 头部异常肥大。映射了少数关键寡头似乎正在垄断这个市场的大部分开发者活动。而人工智能模型的训练成本的降低,也推动了低成本、更小或垂直化大模型的发展,虽然其生态系统要碎片化得多。

这张图也可以看成是 AI 大模型领域的 “集中化 vs. 去中心化”。之前 Web3 推崇许久的去中心化,从这一轮生成式 AI(AGI)的实践看,集中化还是更显竞争优势。