AI 算力更多集中在云端是目前的主流情况。而一套完整的云端 AI 涉及到哪些用于互联的网络呢?

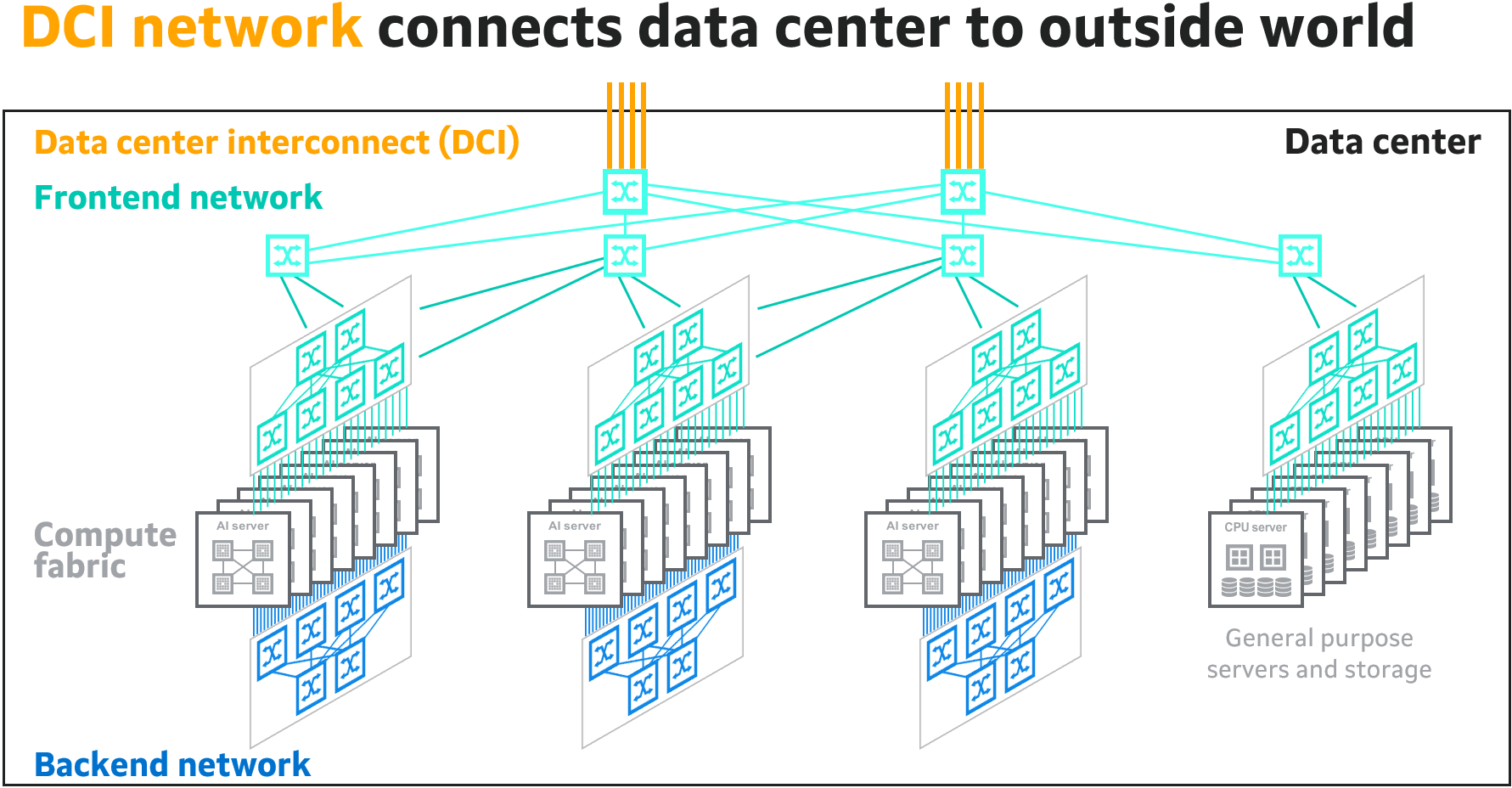

Marvell 在下图做了一个归纳,其认为一共包括四类网络:

(1) Compute fabric(计算架构):连接服务器内的 AI 加速器、GPU、CPU 和其他组件。该架构设计用于在短距离内高速运行,通常依赖于使用 PCIe 或 NVLink 等专有接口的铜线

(2) Backend network(后端网络):使用多层互连的网络交换机和光模块将上述服务器连接成 AI 集群。网络协议包括 InfiniBand 或以太网。

(3) Frontend network(前端网络):将 AI 集群连接到云数据中心,用于存储、交换等。AI 服务器内部的 CPU 负责传输数据,每个 CPU 都有自己的网卡,连接光模块。前端网络使用以太网协议。

(4) Data Center Interconnect (DCI,数据中心互联) :使用 100 公里或更长的链路将一个数据中心与其他区域内的数据中心连接起来。

业绩普遍认为,大模型会在搜索引擎领域发挥很大的作用。OpenAI 也发布了其新的搜索引擎服务 SearchGPT。

Altimeter 的研究认为,以每次搜索查询为例,传统查询每次的成本为 0.3 美分,而大模型搜索的查询成本为每次 3 - 30 美分。查询带来的商业变现角度,传统查询每次可带来 4.5 美分的收入(主要是广告),而大模型搜索带来的收入为每次 2.5~3.5 美分。

从这个角度看,大模型搜索似乎不是一个好生意。

截至 2019 年年底,我国在用数据中心机架总规模达到 314.5 万架,与2018年底相比,增长39%。

超大型数据中心机架规模约117.9万架,大型数据中心机架规模约119.4万架,增速为41.7%。

利用率角度,全国数据中心总体平均上架率为 53.2%。超大型数据中心的上架率为 45.4%,大型数据中心的上架率为 59.8%,中小型数据中心的上架率为 56.4%。

数据中心的利用率有较大潜力空间,一定程度存在 “超量建设” 的现象。

Marvell 认为,如果以 2023 年为分水岭,AI 算力集群的互联网带宽在之前年份大约每隔 4 年会翻倍;而之后年份会提升到每隔 2 年翻倍。

带宽速度是一方面,互联的连接数量也会急剧增加。ChatGPT 在 GPT-3 模型训练时,大约使用了 1,000 个加速器的集群,这需要大约 2,000 个光纤互联连接;而 GPT-4 模型的训练则需要使用 2.5 个加速器的 GPU 集群,这需要大约 7.5 万个光纤互联连接。

光纤互联的连接增长速度将比 XPU/GPU 要块,比例达到 5:1,甚至 10:1。