当前,30 亿参数的 “小模型“ 的性能已经达到最开始 ChatGPT 所使用的 1750 亿参数模型的效果。这得益于更好的压缩技术(distillation 蒸馏、quantization 量化等),以及更高质量的训练数据。

这个小型化过程会带来显著的好处:边缘侧和端侧通常算力是有限的,没办法部署大模型,但小型的模型如果性能够,就可以用的起来。(而边缘和端侧等低延迟特性就可以发挥起来了)。

与此同时,我们也想到了另一个问题,甲方企业 CIO 的难题。通常一个 IT 项目从立项招标到部署应用,起码要耗费几个月,甚至更久的时间。而模型改进(如下图所示)是以月为单位进步的,很可能甲方企业根据标书购买的大模型还没有部署上线,就已经落后,而且落后很多。

大模型时代的 IT 投资保护是一个值得思考的话题。

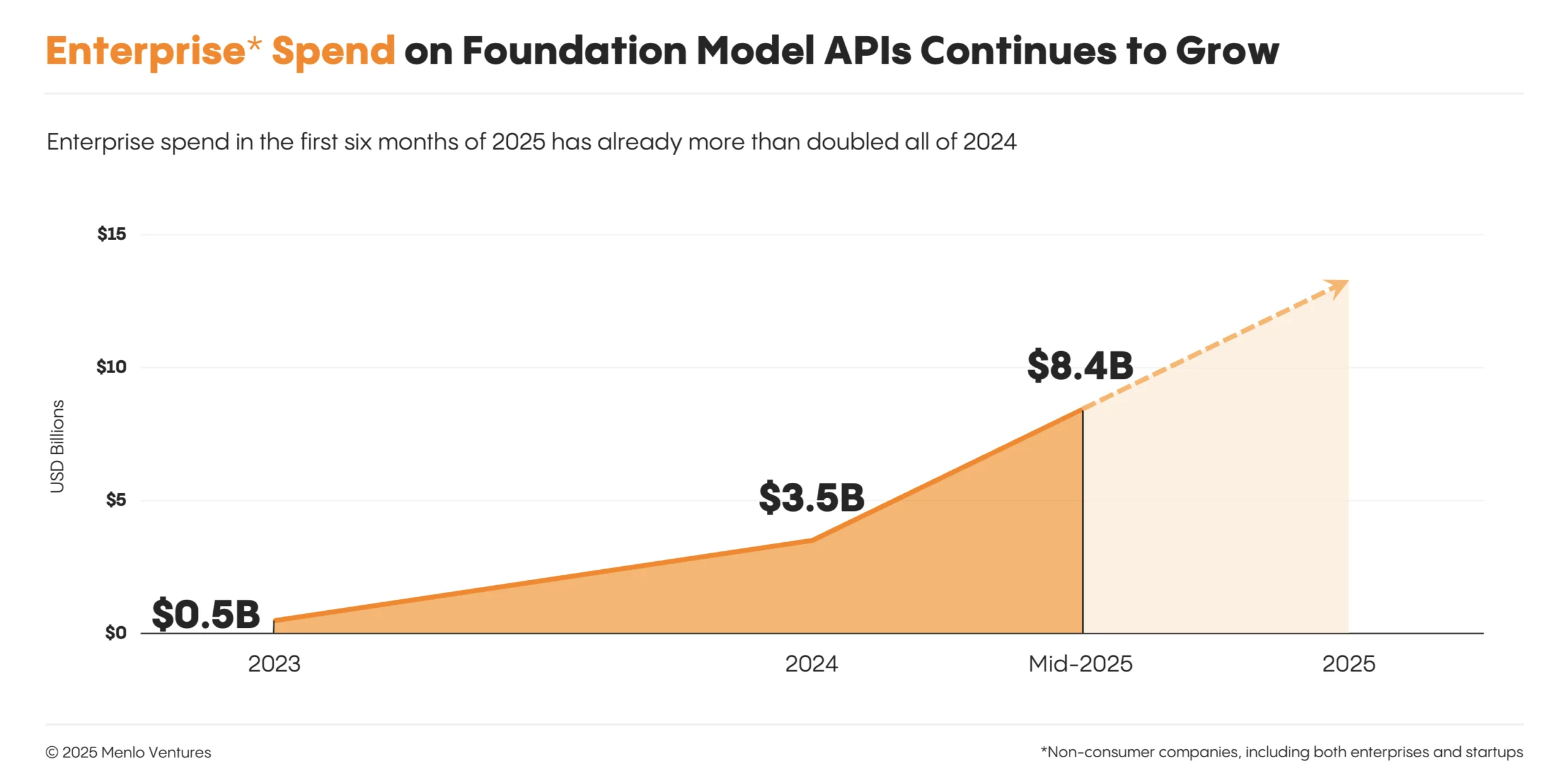

Menlo Ventures 调研显示,Anthropic 正在持续赢得更多企业客户的大模型 API 支出的市场份额。而 OpenAI 的市场份额则从 2023 的 50% 持续下滑到 25%。

OpenAI 和 Anthropic 貌似正在走向不同的侧重点。OpenAI 通过 ChatGPT 牢牢的获得绝大部分消费者 2C 的份额,而 Anthropic 似乎更侧重于企业 2B 侧。

风险投资机构 Altimeter 绘制了一张图对比了目前云计算和生成式 AI 技术栈的收入规模。

云计算是一个倒三角,应用层大约 4000 亿美元,基础设施层 2000 亿美元,半导体芯片层 500 亿美元。

这个结构看起来是健康的,因为最终企业用户,尤其是各行各业和最终消费者会为应用付费。应用服务商获得了收入,才有能力去购买云基础设施(AWS、Azure 等)的服务。进而,云基础设施服务商也有财力去购买更多服务器的芯片。

生成式 AI(Gen AI)目前的状态则正好相反,半导体 GPU 层面有 750 亿收入,而 AI Infra 只有 100 亿美金,Gen AI 应用层则只有 50 亿美金左右。

这是否合理,见仁见智了。