生成式 AI 发展大趋势下,各种大语言模型(LLM)如雨后春笋般出现。除了 OpenAI 的 GPT 和 Google 的大模外,还有各种开源模型。在 Hugging Face 上宣称有 30 万种模型可供选择。

对于应用开发商而言,一种主流的手段就是像使用云计算算力一样,通过互联网 API 去调用大模型服务商的模型能力,然后按照使用次数去付费。

由于不同大模型的计算质量以及品牌有差别,此类 AI 算力服务的价格也差别很大。例如,GPT-4 会比 GPT-3.5-Turbo 贵 30x 倍;GPT-4 比其他某些模型服务商贵甚至 100x 倍。

这就给应用商带来一个问题,对于 “普通的计算请求” 是否也需要用 “很贵的 GPT-4” ?可否用便宜一些的其他模型服务来代替 GPT-4。

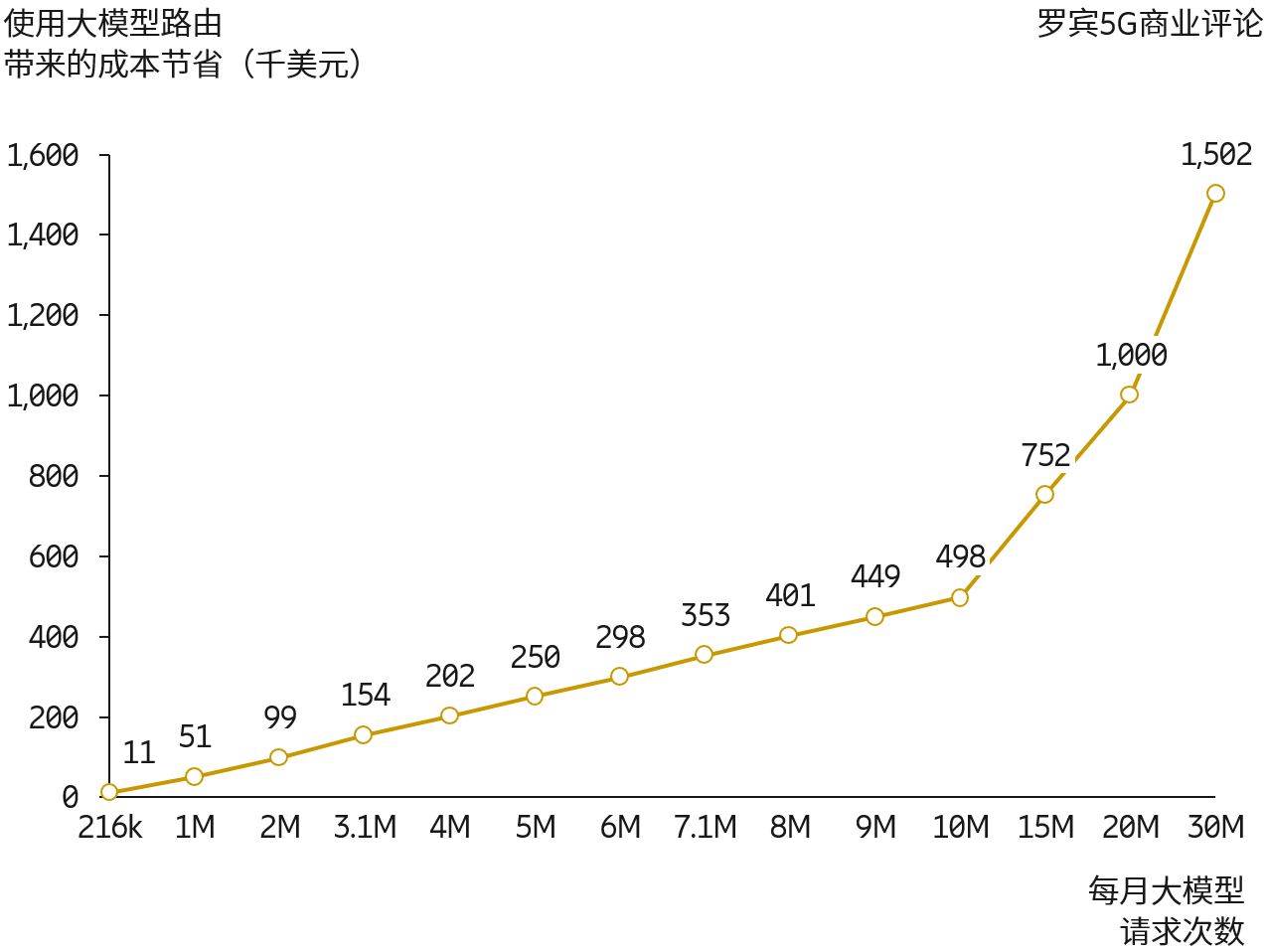

创业公司 Martian 就在走类似事情,其提供了 “Model Router 模型路由” 服务,帮助应用上来做自动路由选择,力求把普通的计算请求应用于便宜一些的大模型服务上去。

附图数据来自 Martian 的模拟,其认为通过模型路由,节省最高 98% 的大模型能力调用成本。

风险投资机构 a16z 描绘了生成式 AI(AGI)的技术栈层次。最底下两层是计算机硬件(服务器、GPU 等)和云平台(AWS、Google 云、Azure 等);

底下两层可认为提供了算力网络的基础设施服务。深蓝色是模型层,包括闭源的模型(例如:OpenAI 的 GPT-3) 和开源模型。开源模型既包括模型算法本身,也包括托管和运行这些模型的平台。

最上层即应用。应用既可以是 Jasper 这种比较 “薄” 的应用,也包括 Midjourney 这种后台模型也自己做的应用。

从价值创造和风险投资角度,Jasper 类面临的质疑就是护城河问题,有风险投资机构认为其大量能力依赖 OpenAI。而 OpenAI 会把大部分价值拿走等。

但其实即便是比较 “薄” 的上层应用中,Github...

Microsoft 信息披露现实,其在 2023 年的碳排放量对比其指定的基准年份(2020年)提升了 29.1%。

AI 带来的能耗提升被认为是碳排放量增加的主要原因。

遇到过若干次类似情况了,论述资本主义和劳资关系时。

同一家公司,前后座位共事的同事财富巨大差别的情形,通常出现在高速成长的巨头身上。一切取决于加入的时间:

⑴ 有钱的 Facebook 人和没钱的 Facebook 人;

⑵(曾经)华为人的工号文化,异性征友有时都会标注,期望多少号之前;

⑶ 不同时期加入阿里的 P8…